OpenAI redevient open… l’espace d’un instant

Analyse rapide des modèles gpt-oss-120b et gpt-oss-20b

Des modèles open-weight

OpenAI, souvent pointé du doigt pour le manque de transparence de ses modèles, a créé la surprise en annonçant début aout 2025 deux modèles open-weight, gpt-oss-120b et gpt-oss-20b. Les modèles open-weight sont des modèles de langage distribués librement par leur créateur, ce qui permet une utilisation sans restriction, à des fins commerciales ou non. En déployant ces modèles sur son propre matériel, il devient également possible de conserver un contrôle total sur les données et la confidentialité des prompts et des réponses générées. Rappelons que le dernier modèle open-weight proposé par OpenAI remontait à 2019, avec GPT-2, autant dire la préhistoire de l'IA.

Avec respectivement 120 et 20 milliards de paramètres, ces modèles s'inscrivent dans les standards du marché et constituent a priori une proposition intéressante, surtout pour les utilisateurs disposant de configurations modestes. Le modèle gpt-oss-20b se positionne ainsi comme un concurrent direct aux modèles légers et très populaires comme Mistral Small (22b) ou Gemma3 en version 27b.

Des modèles MoE avec "Chain of Thought"

Ces deux nouveaux modèles intègrent la technologie Mixture-of-Experts (MoE), une approche qui permet d'activer un nombre limité de paramètres lors de la génération de réponses. Cela allège considérablement le poids du modèle, améliorant ainsi sa performance et son efficacité.

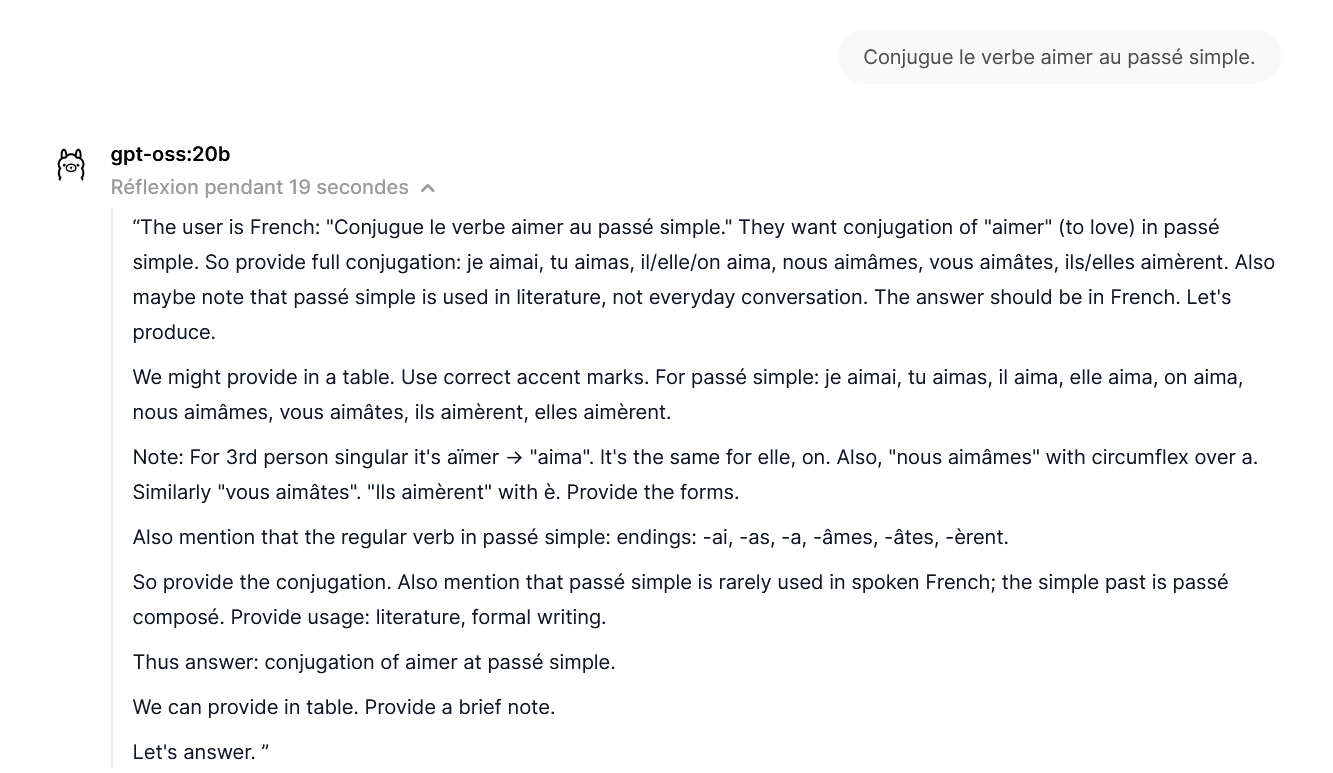

Les modèles gpt-oss embarquent également la fonctionnalité Chain of Thought (CoT), une technique qui simule le processus de raisonnement humain. Avant de fournir une réponse, le modèle construit en amont un véritable raisonnement, ce qui permet d’obtenir des résultats en théorie plus pertinents et justifiés.

Mais qu'est-ce qui se cache derrière cette ouverture soudaine ? Et à qui s'adressent réellement ces modèles ?

Pourquoi cette ouverture inattendue ?

La publication de ces modèles open-weight s'inscrit dans une tendance générale observée chez les acteurs majeurs de l'IA, comme Google avec Gemma, Deepseek avec R1 et Meta avec Llama. Ce mouvement répond à plusieurs objectifs :

- Visibilité dans l'écosystème Open Source: En participant à la scène de l’IA open source, ces entreprises gagnent en notoriété et consolident leur présence dans un marché très compétitif. On se souvient de l'impact de Deepseek à sa sortie, un exemple frappant de ce phénomène.

- Image positive: L'open weight renvoie une image de transparence et d'ouverture, même si les données d’entraînement, cruciales, restent majoritairement opaques.

- Réponse aux critiques: OpenAI est confrontée à des critiques croissantes concernant la qualité de ses derniers modèles (ChatGPT 5 notamment), ses prix, et surtout son manque d'ouverture. Cette sortie pourrait être une tentative de "soulager la pression" et de rétablir un certain équilibre avec d'autres acteurs d'apparence plus vertueux.

Comment utiliser ces modèles ?

OpenAI a choisi de publier ses modèles sur Huggingface, la plateforme de référence pour le partage de modèles de langage. L'entreprise met également en avant dans son communiqué des outils populaires de la communauté open source comme Ollama, signalant ainsi une volonté, relativement nouvelle, de s'adresser directement à cet écosystème.

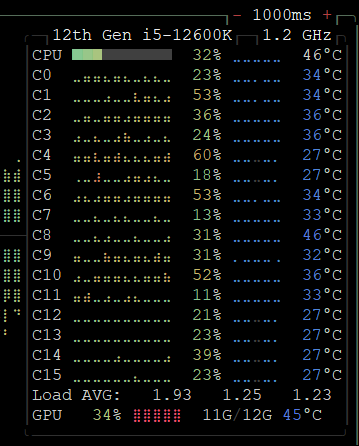

Le modèle gpt-oss-20b est particulièrement intéressant car il peut fonctionner de manière efficiente sur un matériel personnel optimisé. L’auteur de l’article a pu le tester avec succès sur sa propre configuration (RTX 3060 / i5-12600K / 64 Go DDR5).

Comme on peut le voir ici, le processus d'inférence n'est pas hors de portée de la machine.

Vue du processus de pensée...

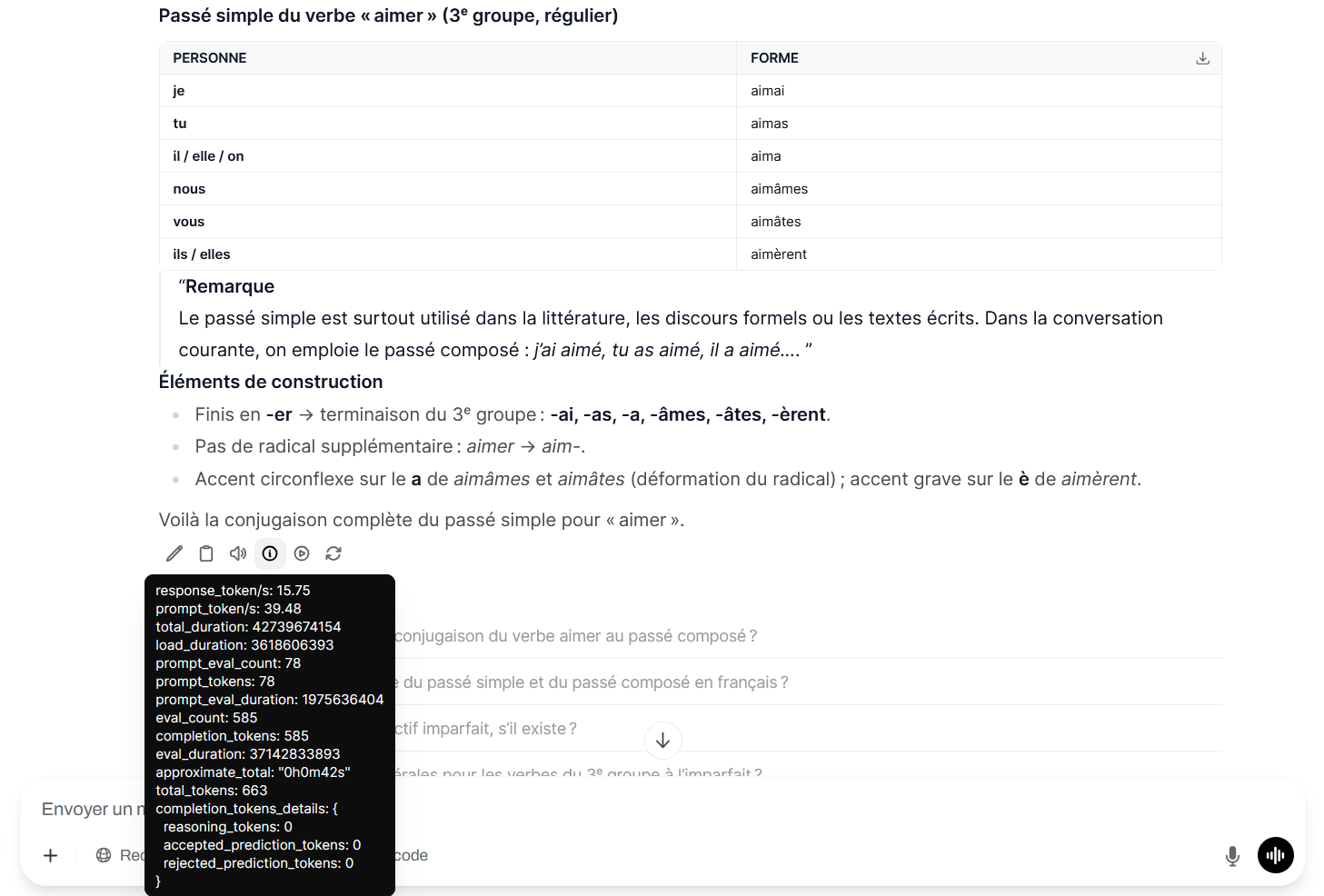

Vue de la réponse définitive avec les statistiques de réponse. On note toutefois que le modèle considère "aimer" comme un verbe du troisième groupe, comme "aller"...

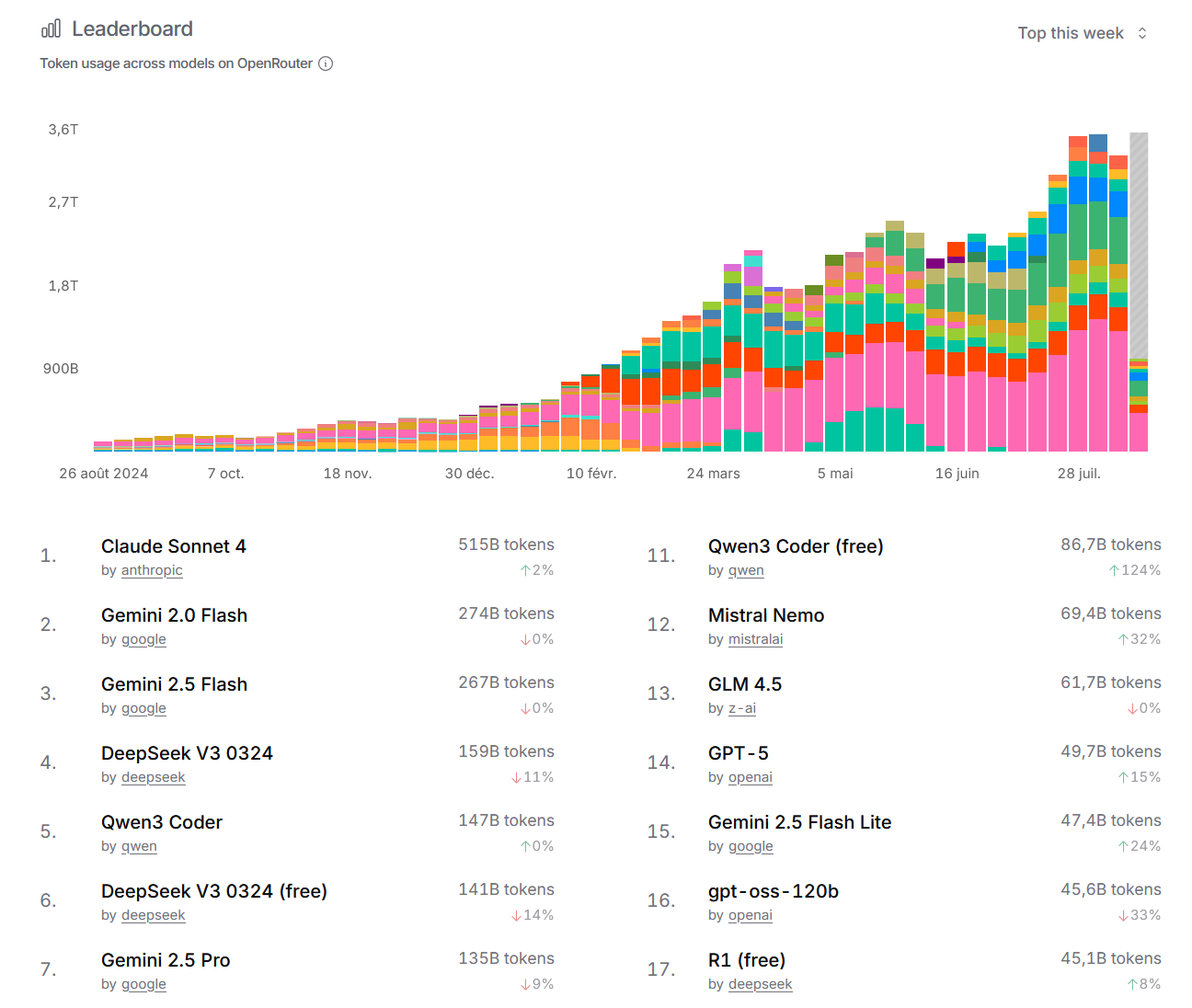

Le modèle gpt-oss-120b, plus compliqué à opérer sur du matériel amateur, est quant à lui proposé par OpenRouter à un tarif compétitif de 0,072 dollar par million de tokens entrants et 0,28 dollar par million de tokens sortants. Cependant, malgré ce tarif percutant, son utilisation est pour l’instant limitée : il se classe seulement 16ème des modèles les plus utilisés sur la plateforme, ce qui confirme le relatif désaveu dont souffre OpenAI sur cette plateforme (le premier modèle, Chat-GPT5, est en 14ème position).

En conclusion : Un pas en avant, mais…

Ces nouveaux modèles sont intéressants à tester, notamment pour les utilisateurs fidèles à OpenAI qui souhaitent combiner leur préférence pour cette entreprise avec le désir d’utiliser des outils plus respectueux de leur vie privée. La version 20b, par exemple, offre un bon compromis entre performance et facilité d'utilisation.

Une utilisation en local permettrait notamment à un établissement scolaire d'expérimenter des usages de l'IA dans un cadre totalement respecteux du RGPD, puisque toutes les données utilisées resteraient dans l'établissement.

Cependant, il ne s'agit pas d'une avancée majeure dans le domaine des LLM. D'autres modèles déjà disponibles sont au moins aussi performants, et il est possible, voire probable, que ces modèles aient été publiés principalement pour répondre aux critiques en matière d'opacité et pour repositionner l'image d'OpenAI. Il sera toutefois intéressant de suivre l'évolution de ces modèles et de leur adoption par la communauté.